移动阅读

智 宁1,2,毛善君1,李 梅1,苏 颖1

(1.北京大学 地球与空间科学学院,北京 100871; 2.中国科学院 电子学研究所,北京 100190)

摘 要:针对现有煤矿尘雾图像清晰化算法存在的过增强现象和适用性不足等问题,提出一种基于深度融合网络的清晰化复原算法。深度融合网络主要包括3个部分,即图像预处理模块、特征融合模块以及图像输出模块。图像预处理模块基于对比度增强函数、亮度增强函数和伽马校正函数对输入图像进行处理,获取表征不同增强方式及程度的图像序列。由于图像尘雾清晰化需要同时考虑图像的局部信息和全局信息,在空间金字塔池化和上下文信息聚合网络的基础上提出了能够实现双向的上下文信息提取的双金字塔模块,该模块包括2个空洞卷积的串联子块,其中1个子块是以对多个尺度的空洞卷积按尺度由小到大进行串联组成,另1个子块是以对多个尺度的空洞卷积按尺度由大小进行串联组成。图像输出模块主要对特征融合层获取的特征进行处理,从而输出三通道图像,即为最终的尘雾清晰化的图像。为了获取训练数据,本文在煤矿井下清晰图像的基础上基于尘雾图像形成机理构建了较大规模的训练数据集。在训练的过程中,采用了最小平方误差损失函数和基于VGG网络的内容损失函数对网络进行优化。为评价本文提出的基于深度融合网络的清晰化算法的有效性,选取其他6种有代表性的清晰化算法进行对比。实验结果显示,本文算法在主观评价和客观评价方面都优于上述算法,表明本文算法能够有效解决过增强现象,并提升煤矿图像的清晰度和可视化效果。

关键词:尘雾图像清晰化;双金字塔模块;深度融合网络;煤矿图像

中图分类号:TD672

文献标志码:A

文章编号:0253-9993(2019)02-0655-12

收稿日期:2018-05-04

修回日期:2018-11-10

责任编辑:常明然

基金项目:国家重点研发计划资助项目(2017YFC0804300)

作者简介:智 宁(1990—),男,山西运城人,助理研究员,博士。E-mail:nzhi@pku.edu.cn

通讯作者:毛善君(1964—),男,四川成都人,教授,博士生导师。E-mail:sjmao@pku.edu.cn

智宁,毛善君,李梅,等.基于深度融合网络的煤矿图像尘雾清晰化算法[J].煤炭学报,2019,44(2):655-666.doi:10.13225/j.cnki.jccs.2018.0606

ZHI Ning,MAO Shanjun,LI Mei,et al.Coal mine image dust and fog clearing algorithm based on deep fusion network[J].Journal of China Coal Society,2019,44(2):655-666.doi:10.13225/j.cnki.jccs.2018.0606

ZHI Ning1,2,MAO Shanjun1,LI Mei1,SU Ying1

(1.School of Earth and Space Sciences,Peking University,Beijing 100871,China; 2.Institute of Electronics,Chinese Academy of Sciences,Beijing 100190,China)

Abstract:A clear restoration algorithm based on deep fusion network is proposed to solve the problem of over enhancement and insufficient applicability of the existing dust and fog image clear restoration algorithm.The deep fusion network mainly includes three parts,namely,the image pre-processing module,the feature fusion module,and the image output module.The image pre-processing module processes the input image based on the contrast enhancement function,the brightness enhancement function,and the gamma correction function to obtain an image sequence that characterizes different enhancement modes and degrees.Because the local information and global information of image need to be taken into account,this paper proposes a double pyramid module which can realize a dual-path context information extraction on the basis of spatial Pyramid pooling and context information aggregation network.The module consists of two series sub-blocks of dilated convolution,one is composed of a series of small to large scale dilated convolution on multiple scales,and the other is composed of a series of large and small scale void convolution on multiple scales.The image output module mainly processes the features acquired by the feature fusion layer,thereby outputting a three-channel image,that is,a clear image.In order to obtain the training data,this paper builds a large-scale training data set based on the dust fog image formation mechanism with the clear coal mine images.In the process of training,this paper uses the least square error loss function and the content loss function based on VGG network to optimize the network.In order to evaluate the effectiveness of the proposed algorithm based on deep fusion network,six other representative clearing algorithms are selected for comparison.The experimental results show that the proposed algorithm outperforms the other six algorithms in subjective evaluation and objective evaluation,which indicates that the proposed algorithm can effectively solve the over-enhancement phenomenon and improve the clarity and visualization of coal mine images.

Key words:dust and fog image clarity;coal mine image;dual pyramid module;deep integration network

煤矿视频图像能够实时传递煤矿井下生产作业及开采环境等信息,在煤矿信息化建设中扮演着重要的角色[1]。由于井下环境特殊,在煤矿煤炭生产、运输等环节产生了大量悬浮于空中的粉尘颗粒;同时,为了避免煤尘过大产生的重大危险,矿井采用了很多喷雾降尘设备,使得矿井产生大量的雾气和水滴。在粉尘颗粒及雾气等的作用下,光线在井下传播过程中发生散射和吸收,造成井下获取图像存在明显的尘雾影响[2],不利于图像信息的判别和进一步的应用。为充分发挥图像在煤矿井下安全生产和监测监控中的作用,有必要对煤矿井下尘雾图像进行清晰化处理。

煤矿井下尘雾图像清晰化算法主要包括3类,即基于模型的清晰化算法[3-5]、基于图像增强的清晰化算法[6-7]和基于学习优化的算法[8-10]。基于模型的清晰化算法是在尘雾图像成像机理的基础上结合先验知识求取清晰图像,其中何凯明等[3]提出的基于暗通道先验原理的清晰化算法得到广泛的应用和研究。基于图像增强的清晰化算法将尘雾图像看作降质图像,并使用对比度增强函数、色调调整函数等来提升图像的视觉效果。随着深度学习的发展,基于学习的优化算法在机器视觉和图像处理领域有了较多的应用,包括卷积神经网络[8-9]、生成对抗网络[10]等。基于学习优化的算法使用机器学习算法来学习清晰图像和尘雾图像之间的映射关系,并利用学习到的知识指导尘雾图像的复原。

现有的尘雾图像清晰化算法在对煤矿图像处理时普遍存在过增强的问题,即处理后图像的整体亮度偏暗,不利于人眼的辨识;同时,现有算法大多针对良好光照下的雾霾环境,对煤矿图像的适用性不足,限制了工程实践中的应用。笔者围绕煤矿井下尘雾图像清晰化问题,将图像处理中的融合策略和深度学习中卷积神经网络结合,提出基于深度融合网络的煤矿图像尘雾清晰化算法。

煤矿尘雾环境下,由于尘雾影响,光线发生散射、吸收、辐射等现象,使得井下获取的图像存在明显的退化现象。在光与悬浮颗粒的交互作用中,光的散射是图像质量影响的关键,而吸收、辐射等方面的影响较少。大气散射作用主要包括2个方面:① 散射作用使得物体表面反射到达成像设备的光能量减少,从而降低光强度;② 散射造成其它物体反射的光(称之为环境光)弥漫在大气中,从而影响物体的成像。NARASIMHAN等[11-12]在McCartney的基础上提出了大气散射模型,该模型主要包含衰减模型和环境光模型,分别刻画大气散射作用的2个方面,可以指导井下尘雾图像清晰化复原。

衰减模型描述了到达成像设备的光强与物体表面反射光强之间的关系,即

Ed(d,λ)=E0(λ)e-β(λ)d(1)

其中,d为物体与成像设备之间的距离,即景深;λ为入射光的波长;E0(λ)为物体表面反射光的光强,即辐照度;β(λ)为大气散射系数,描述单位体积内大气粒子对光线的散射能力。

环境光模型描述大气中其它光源对物体成像的影响,主要包括天空漫反射光、地面反射光以及直射的光源等,可以表示为

Ea(d,λ)=E (λ)(1-e-β(λ)d)(2)

(λ)(1-e-β(λ)d)(2)

式中,E (λ)为总的环境光光强。

(λ)为总的环境光光强。

由式(1),(2)可以看出,由于大气散射的作用,随着景深的增加,入射光的光强呈指数形式衰减,而环境光也越来越多,从而使得图像呈现出灰白色的效果。

在图像处理领域,通常假设散射系数对于各通道是相同的,因此可以将尘雾影响的图像成像模型简化为

Ic(x,y)=Jc(x,y)t(x,y)+A[1-t(x,y)](3)

t=e-βd(4)

其中,c为颜色通道,即红、黄、蓝;t(x,y)为介质传输率,该参数由散射系数β以及景深d决定;A为环境光光强;Ic(x,y)为(x,y)位置上获取的尘雾影响的图像的像素值;Jc(x,y)为无尘雾影响时的图像像素值。为实现图像的清晰化复原,需要求解式(3),但公式中t和A都是未知的,使得该方程的求解是一个未定的问题。

卷积神经网络(Convolutional Neural Network,CNN)是基于前馈神经网络发展的一种深度网络[13]。卷积表示一种特殊的线性运算。早在1998年LeCun等人提出了用于手写字体识别的LeNet,即包含CNN常用的卷积层、池化层以及全连接层。当前,CNN已经被广泛的应用于语音识别、目标识别、图像分类、图像处理等领域,许多机器学习任务准确率得到了很大的提高。

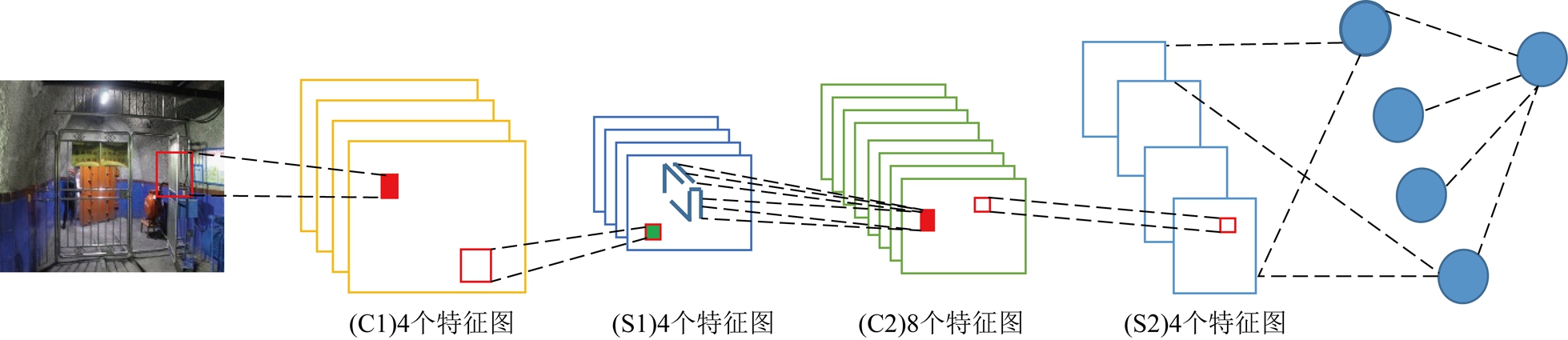

随着CNN的发展,根据不同的应用需求产生了许多新的结构组件。CNN的基本结构通常包括输入层、卷积层(Convolutional layer)、池化层(Pooling Layer)、全连接层(Fully connected layers)以及输出层。一个典型的卷积网络如图1所示,其中C表示卷积层,S表示下采样层。卷积神经网络通过稀疏交互、权值共享、等变表示3个方面有效的提升了机器学习的性能。

图1 卷积神经网络示意

Fig.1 A schematic diagram of convolution neural network

空洞卷积(Dilated Convolution)由YU Fisher等[14]于2016年在国际学习表征会议(International Conference on Learning Representations,ICLR)提出。它是为了解决全卷积网络(Fully Convolutional Network,FCN)在图像分割领域的问题而提出的新的卷积类型。由于空洞卷积具有的良好的处理图像上下文信息的能力,已被广泛的应用于卷积神经网络中,包括自然语言处理、图像超分辨率重建、图像综合处理等。

空洞卷积在传统卷积的基础上扩展而来,本文首先介绍卷积的数学表达式,在此基础上对空洞卷积进行讨论。

令F: 2→

2→ 为离散函数,Ωr=[-r,r]2∩

为离散函数,Ωr=[-r,r]2∩ 2,其中r为滤波半径。k:Ωr→

2,其中r为滤波半径。k:Ωr→ 为(2r+1)2大小的离散滤波。离散卷积操作可以被定义为

为(2r+1)2大小的离散滤波。离散卷积操作可以被定义为

(5)

对式(5)进行推广,令l表示空洞因子,可得空洞卷积的公式:

(6)

式(6)称为尺度为l的空洞卷积。式(4)可以看作为尺度为1的空洞卷积。

图2展示了一般卷积和空洞卷积。以3×3的卷积核为例,传统卷积将卷积核与输入张量中相邻的3×3的区域逐点相乘再求和作为卷积并输出的,如图2(a)所示,红色圆点表示卷积核进行运算输入的位置,绿色可以认为是原输入感知野。空洞卷积则是将卷积核与输入张量的间隔一定位置的3×3像素进行运算并输出,如图2(b)所示,若去掉一个池化层,则需要将传统卷积层换成一个尺度为2的空洞卷积层。这样,卷积核将输入张量每隔一个“像素”的位置作为输入区域进行计算。此时,相比于原输入,卷积运算的感知野扩大为7×7;同理,若再去掉一个池化层,则需要将之后的卷积层换成尺度为4的空洞卷积层,如图2(c)所示。由此可见,空洞卷积能够保证网络在舍弃掉池化层之后其感知野仍保持不变,从而保障图像上下文信息参与到图像局部和全局信息的提取。

图2 空洞卷积示意

Fig.2 Schematic diagram of dilated convolution

根据尘雾图像成像机理,尘雾图像清晰化需要同时考虑全局信息(环境光的强度)和局部信息(介质传输率或景深),因此在设计网络的时候需要添加某种机制实现上下文信息的交互。将在空洞卷积的基础上提出一种更加有效的实现上下文交互的模块即双金字塔模块实现图像的尘雾清晰化。

为实现煤矿井下尘雾图像清晰化复原,本文构建了基于融合策略的多尺度图像清晰化网络。相比于现有的清晰化网络,本文提出的网络具有如下特点:① 受基于融合策略的图像处理算法的启发,提出了深度融合网络,实现了图像端对端的清晰化处理;② 基于空洞卷积设计了能够进行双向多尺度上下文信息融合的双金字塔模块,相比于空洞空间金字塔池化,该模块能够更加有效的实现图像全局信息的提取。

受图像处理中融合策略的启发,通过提取图像各方面的特征并进行融合,可以使网络能够兼顾图像的对比度、色度、显著性等各方面的优点,最终取得更好的效果。设计了基于融合策略的图像预处理。

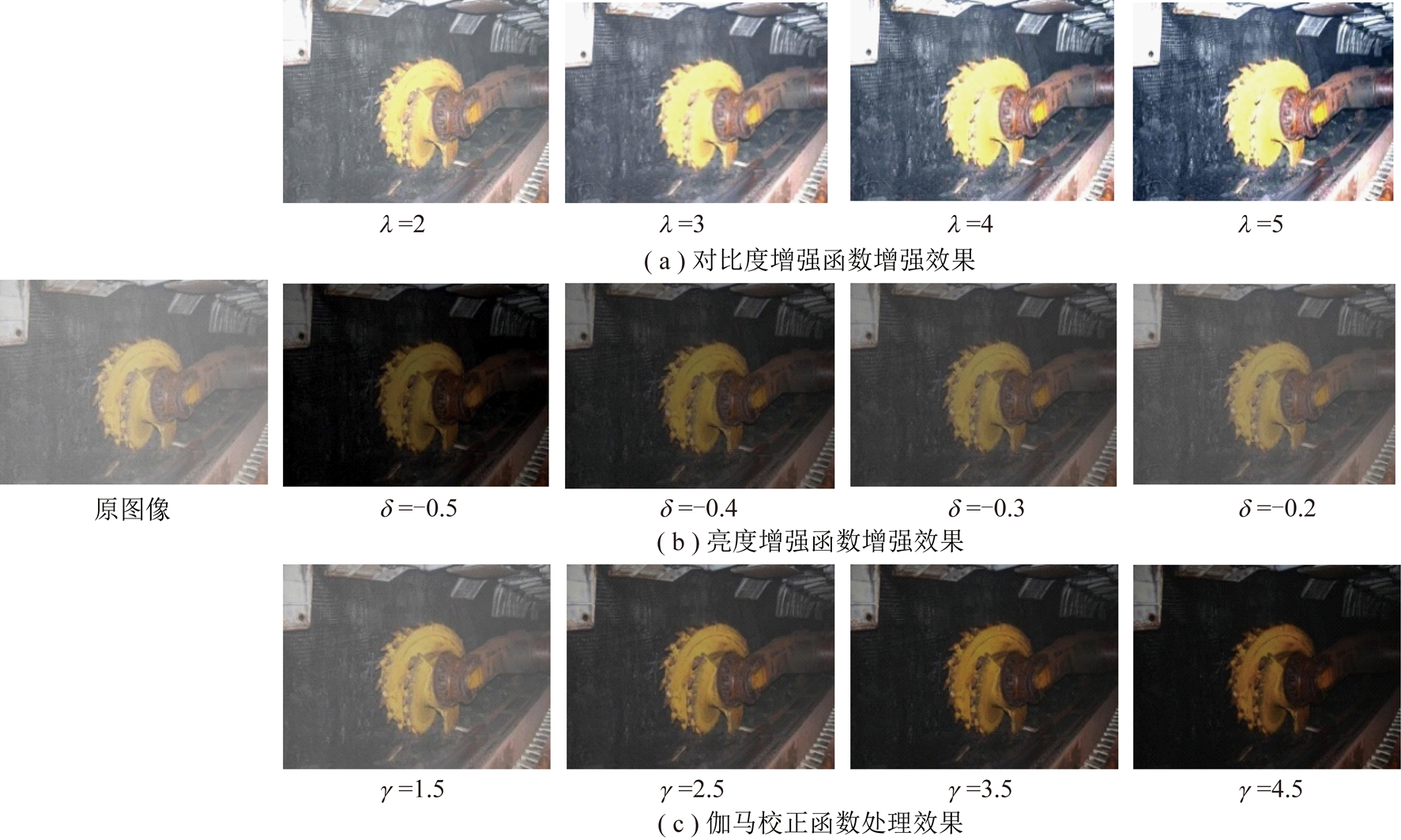

在融合策略的尘雾图像去雾算法中,需要首先提取图像的特征图。参考ANCUTI等[6]做法,特征图主要包括2个方面,即图像的色调调整和图像的对比度增加。本文选择图像对比度增强函数、亮度增强函数和伽马校正函数来进行图像预处理。

本文选取的图像对比度增强函数的表达式为

(7)

式中,Ic为原图像各通道像素值,c为通道,即![]() 为图像各通道的像素均值;

为图像各通道的像素均值;![]() 为输出图像各通道;λ为图像对比度增强系数,其取值范围为[-5,5]。

为输出图像各通道;λ为图像对比度增强系数,其取值范围为[-5,5]。

选取的亮度调整算法为

(8)

其中,![]() 为亮度调整后的输出图像;δ为亮度调整值,其取值范围为[-0.5,0.5]。由于尘雾的存在,图像的整体泛白,因此需要将δ设置为负数,从而一定程度上还原图像本身色彩。

为亮度调整后的输出图像;δ为亮度调整值,其取值范围为[-0.5,0.5]。由于尘雾的存在,图像的整体泛白,因此需要将δ设置为负数,从而一定程度上还原图像本身色彩。

选取的伽马校正算法的表达式为

(9)

其中,![]() 为伽马校正后的输出图像;γ为伽马校正系数,其取值范围通常为[0.05,5],当γ>1时,输出图像的整体亮度比原图像低;当γ<1时,输出图像的整体亮度比原图像高;χ为图像增益系数,一般设为0。

为伽马校正后的输出图像;γ为伽马校正系数,其取值范围通常为[0.05,5],当γ>1时,输出图像的整体亮度比原图像低;当γ<1时,输出图像的整体亮度比原图像高;χ为图像增益系数,一般设为0。

由于网络输入图像的像素值分布未知,不能够自适应的调整上述算法的参数。为此,分别为每种算法设置4个不同的参数,从而使其能够获取不同程度的图像特征。具体来讲,设置图像对比度增强算法中的参数λ为{2,3,4,5};设置图像亮度调整算法中的参数δ为{-0.5,-0.4,-0.3,-0.2};设置伽马校正算法中的参数γ为{1.5,2.5,3.5,4.5}。图3展示了图像预处理的效果。3个增强函数都能够突出图像某方面的特征,为此将预处理后的图像进行连接操作(concat)然后整体输入到网络中。

为了提取图像中多尺度的上下文信息,许多研究者在空洞卷积的基础上提出了新型的网络架构,主要包括空洞空间金字塔池化技术[15]以及上下文信息聚合网络[16]。空洞空间金字塔池化(Atrous Spatial Pyramid Pooling,ASPP)是将多个尺度的空洞卷积并联,实现图像多尺度上下文信息的提取,如图4(a)所示。上下文信息聚合网络(Context aggregation network)由陈启峰等[16]提出。该网络主要是通过对多个尺度的空洞卷积按尺度由小到大进行串联实现了图像多尺度信息的提取,如图4(b)所示。

ASPP以并联的方式将多个尺度信息提取并融合,完成上下文信息的提取。上下文信息聚合网络以串联的方式对图像多个尺度的信息进行提取和融合,并且随着网络层数的增加,空洞卷积的尺度也逐渐增加。对于图像处理,这种信息提取的顺序是有失偏颇的。以图像尘雾清晰化复原为例,环境光等全局信息

图3 图像预处理效果

Fig.3 Schematic diagram of image preprocessing results

图4 基于空洞卷积的3种多尺度上下文交互信息模式

Fig.4 Three kinds of context information extraction models based on dilated convolution

应该参与网络各个阶段的特征处理,而并非在网络的最后阶段参与运算。在ASPP和上下文信息聚合网络的基础上,提出了双金字塔模块。该模块包括两个空洞卷积的串联子块,其中一个子块是以对多个尺度的空洞卷积按尺度由小到大进行串联组成,另一个子块是以对多个尺度的空洞卷积按尺度由大小进行串联组成,如图4(c)所示。然后将这2个串联子块进行并联,从而构成双金字塔模块。该模块能够发挥ASPP和上下文信息聚会网络的优点,使图像的多尺度信息在多个层次和多个方面进行融合,从而有望提升图像处理的精度。

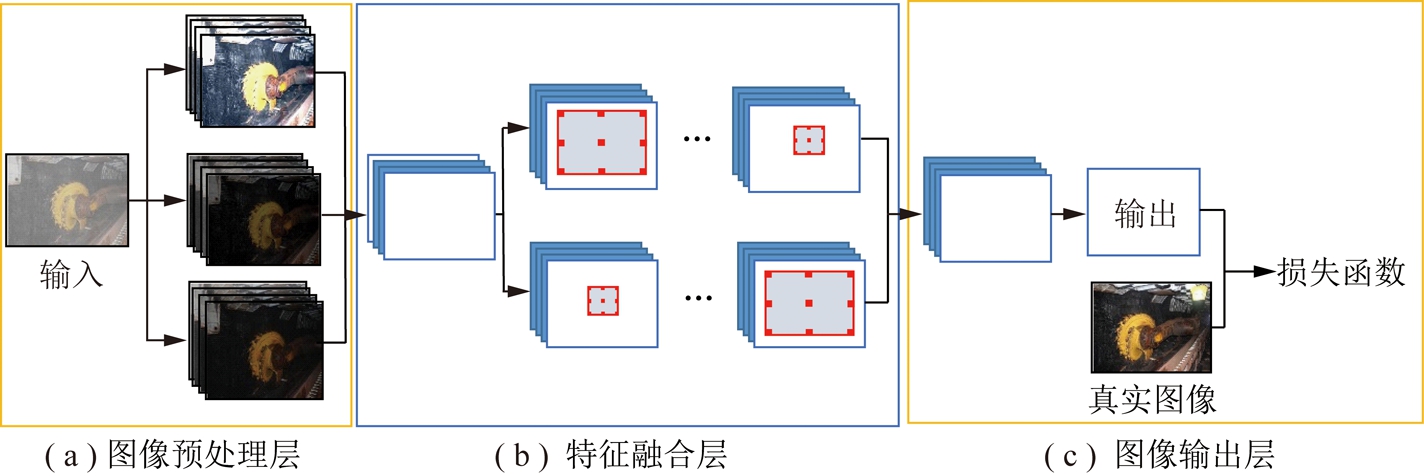

提出的深度融合网络主要包括3个部分,即图像预处理层,特征融合层以及图像输出层。深度融合网络的网络结构如图5所示。

(1)图像预处理层。

图像预处理层对输入图像进行预处理,得到不同增强函数下不同增强参数处理后的图像序列。本文中,分别使用对比度增强函数、亮度调整函数、伽马校正函数对其进行处理,每类函数设置4个不同的增强参数,从而得到12幅反映尘雾图像不同方面特征的图像序列。然后对获取的12幅图像进行连接(concat)操作,得到预处理后的图像的特征张量。

(2)特征融合层。

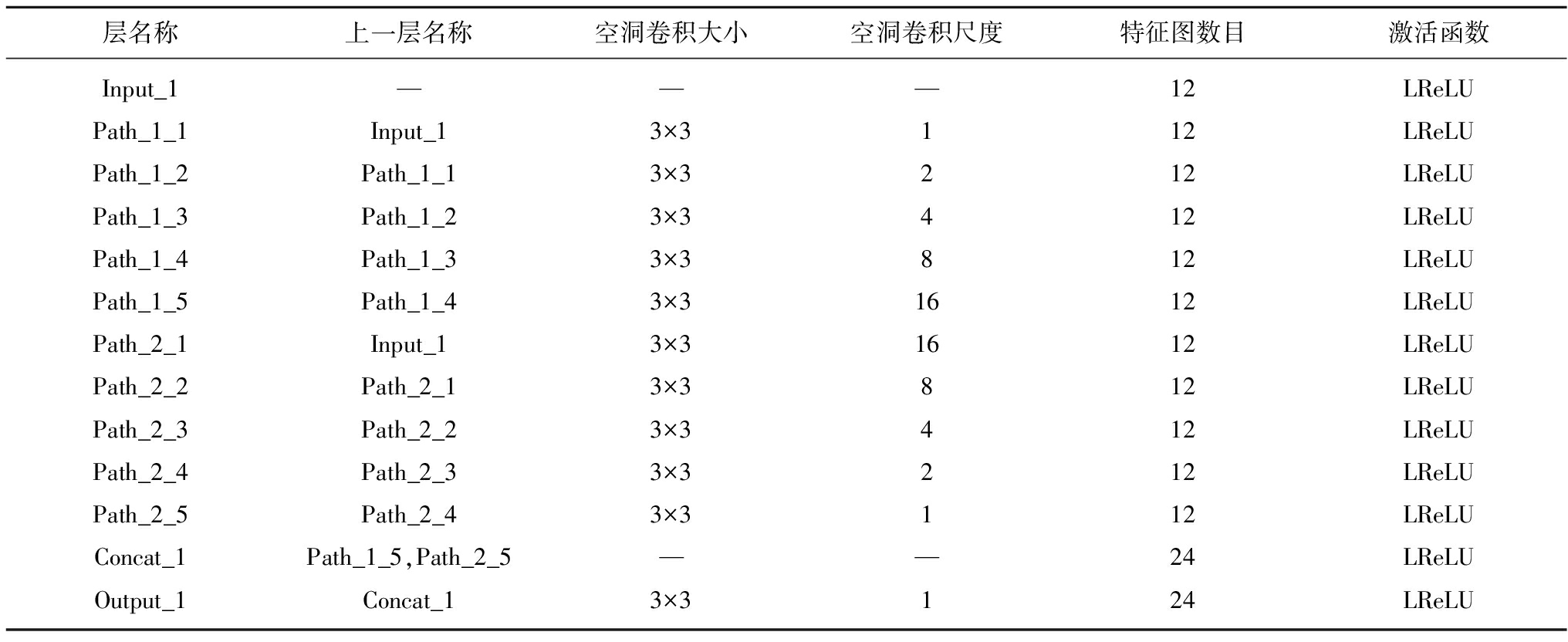

特征融合层主要对反映尘雾图像不同方面特征的图像序列的特征进行融合,从而获取最终的清晰化图像。根据尘雾图像的成像机理,图像尘雾清晰化需要对图像的全局信息和局部信息同时进行提取,使用双金字塔模块,实现从上到下和从下到上双通管道的图像多尺度上下文信息的提取。两条路线上的空洞卷积分别按序列{1,2,4,8,16}及{16,8,4,2,1}进行串联。双金字塔模块的具体参数见表1。

图5 深度融合网络结构示意

Fig.5 Schematic diagram of deep fusion network structure

表1 双金字塔模块参数

Table 1 Dual pyramid module parameters

(3)图像输出层。

图像输出层主要对特征融合层获取的特征进行处理,从而输出三通道图像,即为最终的尘雾清晰化图像。1×1卷积核相当于使用多个线性函数拟合函数,能够增加不同通道间的信息交互,从而提升网络的拟合能力。同时,相比于全连接,能够有效降低图像的参数,提升网络效率。

本文使用一类线性修正单元Leaky ReLU或LReLU[17]作为激活函数。该单元能够在一定程度上解决激活函数激活值为0的问题,即“dying ReLU”。Leaky ReLU的表达式为

(10)

其中,a为一个比较小的常量,在此取a=0.2。由式(10)可以看出,当x<0时,激活函数将有一个非常小的斜率即a。笔者提出的融合网络参数见表2。

表2 深度融合网络模型参数

Table 2 Parameters of deep fusion network

深度融合网络需要使用尘雾图像和对应的清晰图像构成的成对数据进行训练。由于很难获取同一位置下的清晰图像和尘雾图像,选择在清晰图像的基础上进行仿真获得尘雾图像。用Ii表示煤矿井下的清晰图像,用f(Ii)表示基于尘雾图像机理仿真得到的井下尘雾图像。深度融合网络的参数主要包括卷积核的权重![]() 及偏置项参数

及偏置项参数![]() 通过优化网络参数,从而实现对图像尘雾特征的学习并最终恢复出清晰图像,即

通过优化网络参数,从而实现对图像尘雾特征的学习并最终恢复出清晰图像,即

(11)

其中,L(·)为损失函数项;N为训练样本的个数;![]() 为深度融合网络。采用两种损失函数,分别为最小平方误差(Mean-Squared Error,MSE)损失函数和基于VGG网络的内容损失函数(Content Loss Function)。

为深度融合网络。采用两种损失函数,分别为最小平方误差(Mean-Squared Error,MSE)损失函数和基于VGG网络的内容损失函数(Content Loss Function)。

最小平方误差损失函数主要是最小化网络输出图像![]() 和监督图像即清晰图像Ii在RGB色彩空间上的逐像素的误差:

和监督图像即清晰图像Ii在RGB色彩空间上的逐像素的误差:

(12)

由于最小平方误差损失函数与图像整体的感知保真关系较少[18],受Dosovitskiy[19]启发,本文基于预训练完成的VGG-19网络构建内容损失函数。内容损失的衡量是通过将两幅图像输入到预训练好的VGG-19网络中,考察它们在某些激活层后特征的误差,学习图像在内容和感知层面的相似性。令φj(·)表示图像输入到VGG-19网络后获取的第j个卷积层后特征图,则内容损失函数可以表示为网络输入图像![]() 和清晰的目标图像Ii的特征图之间误差的欧式距离,即

和清晰的目标图像Ii的特征图之间误差的欧式距离,即

(13)

其中,Cj,Hj及Wj分别为特征图的通道数目、高和宽。

最终,深度融合网络的损失函数可以表示为最小平方误差损失函数和内容损失函数的加权和,即

L=Lmse+0.8Lcontent(14)

其中内容损失函数是在VGG-19网络的基础上提取relu_5_4层的输出特征图进行计算的。

为了更好的训练网络,采用分步训练的方式,首先使用自然场景下获取的仿真数据对网络进行初步训练,然后使用防爆相机获取井下多个场景的清晰图像的基础上构建的数据集对网络进行精准训练。深度信息的获取是尘雾仿真图像获取的关键。自然场景下的雾霾仿真图像常使用的数据集包括Make3D数据集[20],KITTI数据集[21]等,对于煤矿井下图像,当前缺乏带有深度图的数据集。在此,笔者将着重介绍煤矿井下尘雾图像仿真数据集的构建方法。

考察煤矿井下图像可以发现,图像的像素值和景深符合一定的相关性,即像素值比较小的区域其景深相对比较大,而像素值比较大的区域其景深相对比较小。为此,通过对图像的负片进行操作获取图像的随机深度值,进而获取仿真的煤矿尘雾图像。

算法流程为:

(1)将原图像J从RGB颜色空间转换到HSV颜色空间,并提取图像的明度(V)通道,用Jv表示;

(2)使用带有保边特性的双边滤波器对Jv进行滤波,获取模糊后的图像,用 BF(Jv)表示;

(3)对BF(Jv)进行归一化,然后进行求反操作,获得负片I=1-BF(Jv);

(4)设置随机变量x∈[3,15],然后获得原图像的随机深度图D=x*I;

(5)设置随机环境光A∈[0.6,1],以及散射系数β∈{0.4,0.6,0.8,1.0,1.2},根据式(3)生成仿真尘雾图像。

煤矿尘雾图像生成过程如图6所示。

图6 煤矿尘雾图像生成算法流程

Fig.6 Coal mine dust simulation image generation algorithm flow chart

考虑到尘雾水平的不一致,针对每幅图像分别生成4张不同尘雾程度的尘雾仿真图像。最终,构建的自然场景下雾霾图像数据集共包括2 000幅图像,其中1 500幅作为训练集,500幅作为测试集;构建的煤矿尘雾图像数据集共包括5 200幅图像,其中照度均衡的尘雾图像3 600幅,低照度的尘雾图像1 600幅,将其中的3 900幅图像作为训练集,1 300幅图像作为测试集。

使用Adam算法实现对深度融合网络的优化。Adam算法即自适应矩估计(adaptive moment estimation),它能够根据损失函数,对网络中每个参数梯度的一阶矩估计和二阶矩估计进行动态调整。Adam 算法由基于梯度下降的方法发展而来,但每次都会将迭代参数的学习步长限定在固定的范围内,同时使参数的值保持比较稳定。算法的学习率设置为α=0.001。参照文献[16]的方式,将整张图片输入到网络中进行计算。在前50轮迭代中,使用基于Make3D构建的仿真数据集进行训练,使深度融合网络能够获取到与深度相关的尘雾特征信息,进而在后续150轮迭代中使用煤矿尘雾图像数据集进行训练,并获得最终结果。

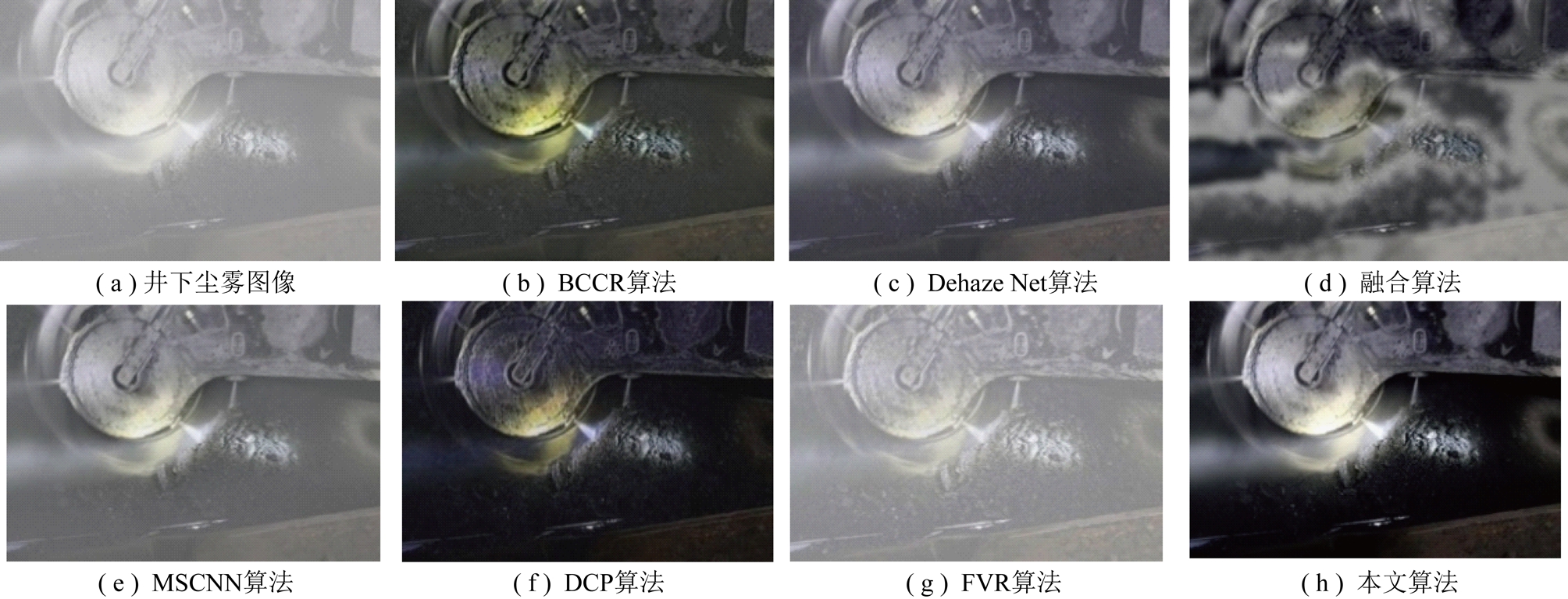

为评价本文提出的基于深度融合网络的清晰化算法的有效性,选取其他6种有代表性的清晰化算法进行对比,包括孟高峰等[22]提出的基于边界约束和上下文正则化的尘雾清晰化算法(Efficient Image Dehazing with Boundary Constraint and Contextual Regularization,BCCR),蔡博仑等[8]提出的基于卷积神经网络的DehazeNet算法,ANCUTI等[6]提出的基于融合策略的清晰化算法,任文琦等[9]提出的基于多尺度卷积神经网络的雾霾清晰化(MultiScale Convolution Neural Network,MSCNN)算法,何凯明等[3]提出的基于暗通道先验原理(Dark channel priori,DCP)的清晰化算法,TAREL等[5]提出的快速可视化复原(Fast Visibility Restoration,FVR)算法进行对比。相关算法的代码均来自于作者提供的项目网站,且均基于matlab实现。其参数参照论文中推荐的参数进行设置。

实验对比的部分结果如图7~11所示。由图中可以看出,基于融合的尘雾清晰化算法和快速可视化复原算法对于煤矿井下尘雾图像的复原效果比较差。基于融合的尘雾清晰化算法使得图像的尘雾分布更加不均匀,只能对于对比度比较大的部分区域实现清晰化复原。这主要是由于融合策略下的权重图设计的不尽合理,如显著性权重图在煤矿尘雾图像的清晰化中意义不大。快速可视化复原算法使得图像的局部对比度有所增加,如图8中运输车上的锈痕部分,但图像整体泛白,并未有效实现尘雾的清晰化。

图7 场景1尘雾清晰化实验对比结果

Fig.7 Comparison results of dust and fog image clear restoration algorithms (Scene 1)

图8 场景2尘雾清晰化实验对比结果

Fig.8 Comparison results of dust and fog image clear restoration algorithms (Scene 2)

图9 场景3尘雾清晰化实验对比结果

Fig.9 Comparison results of dust and fog image clear restoration algorithms (Scene 3)

图10 场景4尘雾清晰化实验对比结果

Fig.10 Comparison results of dust and fog image clear restoration algorithms (Scene 4)

图11 场景4尘雾清晰化结果局部效果

Fig.11 Comparison local results of dust and fog image clear restoration algorithms (Scene 4)

BCCR算法、DehazeNet、MSCNN算法以及基于暗通道先验原理的去雾算法清晰化效果都比较明显。这些算法都有效的解决了图像泛白的问题,并且图像整体的对比度均有所胜,图像的细节有所突显。

DehazeNet和MSCNN算法都是基于卷积神经网络实现的图像尘雾清晰化算法。两种网络都能够在一定程度上实现对煤矿井下尘雾清晰化的复原。但清晰化效果并不明显。如图7~11所示,处理后图像的白化现象有所减弱,但仍然给人以尘雾的感觉。这主要是由于:① 两种网络对图像多尺度的上下文信息提取的能力不足,使得图像清晰化效果不明显;② 两种网络的训练数据均为理想光照下的尘雾仿真图像,从而使得针对煤矿图像尘雾图像的清晰化效果较差。

基于暗通道先验原理的清晰化算法和BCCR算法处理的图像整体清晰度和对比度都有所增强,尘雾图像所特有的泛白现象也得到解决。基于暗通道先验原理的清晰化复原算法在图像部分区域存在明显的晕圈效应,即边缘部分存在明显的白边。这主要是由于以下原因:① 暗通道先验原理主要适用于室外无雾图像,对于受限空间内图像的适用性有待验证;② 基于暗通道先验原理的去雾算法使用软抠图实现介质传输图的精细化。BCCR算法通过边缘约束和上下文正则化,将精细介质传输图的求解转化为优化问题。由于存在边缘约束及上下文正则化,使得通过优化获取的介质传输图更加精细,从而有效避免了光晕现象的产生,其去雾效果相较于基于暗通道先验原理的去雾算法更加明显和准确。

DCP算法和BCCR算法均存在明显的过增强现象,即处理后的图像整体上偏暗。图7~10中除颜色变化和对比度变化较大的区域能够较好的实现图像复原,其它色彩单调和对比度较小的区域如墙壁等,都存在严重的过度清晰化问题。图11为图10的局部放大图像,由图11中可以看出,BCCR算法和基于暗通道先验原理的算法处理后的墙壁颜色亮度比较低,偏离了正常的墙壁颜色。这主要是由于以下原因:① 暗通道先验原理是对大量室外无雾图像的统计得到的,在原理提出之初就面临着天空区域不符合该先验原理的问题。对于煤矿井下获取的图像,图像的色彩和对比度相对比较单一,例如巷道的墙壁、机械设备的表面等,这些区域并不满足图像的暗通道先验原理。因此,容易出现过度清晰化的现象。② 两种方法都是基于尘雾图像的机理实现图像的复原,不同于景深变化相对较大的室外图像,井下获取图像的景深变化一般都比较小。2种方式在求取图像介质传输图时,都倾向于将景深的变化估计的比较大,极易造成图像过增强的现象。

相比于其它算法,本文算法的清晰化结果能够有效解决图像的泛白问题,恢复图像原有的色彩和对比度,实现图像清晰度和对比度的提升。

在图像增强方面,结构相似度指数(Structural Similarity Index,SSI)和峰值信噪比(Peak Signal to Noise Ratio,PSNR)被广泛应用于处理后的图像质量。为衡量图像去雾的水平,本章将通过计算这2个客观指标对上述所列方法进行评价。

SSIM通常用来衡量两幅图像相似的程度,如SSIM值越大,表示图像失真越小,当两幅图像完全一样时,取值为1。SSIM的计算公式为

(15)

式中,x,y为需要计算相似度的两幅图像;μx为x的均值;μy为y的均值;![]() 为x的方差;

为x的方差;![]() 为y的方差;σxy为x和y的协方差;c1和c2为微小的扰动量。

为y的方差;σxy为x和y的协方差;c1和c2为微小的扰动量。

峰值信噪比是另一种有参考的图像客观评价指标。通常,PSNR的数值越大表示处理后的图像失真越小,它的计算公式为

(16)

![]() (17)

(17)

式中,n为每个像素的比特数,通常为8;MSE为处理后的图像I和原图像即参考图像R的均方误差;M为图像像素数;Ii和Ri表示处理后的图像I和原图像即参考图像R在位置i的像素值。

为客观评价算法效率,使用结构相似度指数和峰值信噪比对4.2节的尘雾图像进行评价。表3为尘雾图像清晰化各算法的客观指标评价结果。

由表3可以看出,除融合算法之外,其它6种算法能够在一定程度上提升图像清晰化程度。本文算法在大多数图像的结构相似度指数中都取得了最高的分数,表明本文算法能够有效保持原图像的细节结构信息,处理结果与真实无尘雾图像最接近。就各图像结构相似度指数的平均值而言,DehazeNet和MSCNN算法取得了第二、第三的结果,表明两种算法都能够在在一定程度上实现煤矿尘雾图像的清晰化。

表3 尘雾图像清晰化各算法客观指标评价结果

Table 3 Objective evaluation results of dust and fog image clear restoration algorithms

同时,由表3可以看出,除融合算法和快速可视化恢复(FVR)算法之外,其它5种算法都有效减少了图像的失真。本文算法处理后的图像的峰值信噪比都是最高的,表明本文算法能够非常好的恢复尘雾图像,使得清晰化恢复后的图像更加接近真实图像。另外,DehazeNet和MSCNN算法处理的结果紧随本文算法,其次是BCCR算法和基于暗通道先验原理的清晰化算法。出现这种现象的原因是BCCR算法和基于暗通道先验的清晰化算法在处理煤矿井下尘雾图像存在过度清晰化的问题。从视觉效果来看,两种算法处理的图像的清晰度和对比度都比较高,但由于过度清晰化的原因,使得图像中色彩和对比度单一的区域信息损失比较大。

本文提出了一种基于深度融合网络的煤矿图像尘雾清晰化方法。对于输入图像,深度融合网络首先提取输入图像在不同的图像增强方法及增强参数下的特征图,然后对其融合输入到网络中。在深度融合网络的设计中,基于空洞卷积提出了能够进行双向的上下文提取的双金字塔模块,并用于对尘雾图像全局和局部信息的提取。实验表明,基于深度融合网络的清晰化算法在主观评价和客观评价方面(PSNR,SSIM)均优于经典的尘雾清晰化算法。

参考文献

[1] 毛善君.“高科技煤矿”信息化建设的战略思考及关键技术[J].煤炭学报,2014,39(8):1572-1583.

MAO Shanjun.Strategic thinking and key technology of informatization construction of high-tech coal mine[J].Journal of China Coal Society,2014,39(8):1572-1583.

[2] 张谢华,张申,方帅,等.煤矿智能视频监控中雾尘图像的清晰化研究[J].煤炭学报,2014,39(1):198-204.

ZHANG Xiehua,ZHANG Shen,FANG Shuai,et al.Clearing research on fog and dust images in coalmine intelligent video surveillance[J].Journal of China Coal Society,2014,39(1):198-204.

[3] HE K,SUN J,TANG X.Single image haze removal using dark channel prior[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2011,33(12):2341-2353.

[4] FATTAL R.Dehazing using color-lines[J].Acm Transactions on Graphics,2014,34:1-14.

[5] TAREL J P,HAUTI RE N.Fast visibility restoration from a single color or gray level image[A].IEEE,International Conference on Computer Vision[C].IEEE,2010:2201-2208.

RE N.Fast visibility restoration from a single color or gray level image[A].IEEE,International Conference on Computer Vision[C].IEEE,2010:2201-2208.

[6] ANCUTI C O,ANCUTI C.Single image dehazing by multi-scale fusion[J].IEEE Transactions on Image Processing,2013,22(8):3271-3282.

[7] FAN T,LI C,MA X,et al.An improved single image defogging method based on Retinex[A].International Conference on Image,Vision and Computing[C].IEEE,2017:410-413.

[8] CAI B,XU X,JIA K,et al.DehazeNet:An end-to-end system for single image haze removal[J].IEEE Transactions on Image Processing,2016,25(11):5187-5198.

[9] REN W,LIU S,ZHANG H,et al.Single image dehazing via multi-scale convolutional neural networks[A].Computer Vision-ECCV 2016[C].Springer International Publishing,2016:154-169.

[10] 李策,赵新宇,肖利梅,等.生成对抗映射网络下的图像多层感知去雾算法[J].计算机辅助设计与图形学学报,2017,29(10):1835-1843.

LI Ce,ZHAO Xinyu,XIAO Limei,et al.Generative adversarial mapping nets with multi-layer perception for image dehazing[J].Journal of Computer-Aided Design and Computer Graphics,2017,29(10):1835-1843.

[11] NARSIMHAN S G,NAYAR S K.Shedding light on the weather[A].2003 IEEE Computer Society Conference on Computer Vision and Pattern Recognition[C],2003,1:I-665-I-672.

[12] NARSIMHAN S G,NAYER S K.Interactive (De) weathering of an image using physical models[A].IEEE International Conference on Computer Vision Workshop on Color and Photometric Methods in Computer Vision[C].New York:[s.n.],2003:1-8.

[13] IAN Goodfellow,YOSHUA Bengio,AARON Courville.深度学习[M].赵申健等,译.北京:人民邮电出版社,2017:199.

[14] YU F,KOLTUN V.Multi-scale context aggregation by dilated convolutions[A].International conference on learning representations[C].2016.

[15] FU X,ZENG D,HUANG Y,et al.A fusion-based enhancing method for weakly illuminated images[J].Signal Processing,2016,129(J):82-96.

[16] CHEN Q,XU J,KOLTUN V.Fast image processing with fully-convolutional networks[A].International Conference on Computer Vision (ICCV)[C],2017.

[17] MAAS A L,HANNUN A Y,NG A Y.Rectifier nonlinearities improve neural network acoustic models[A].International Conference on Machine Learning[C].2013.

[18] WANG Z,BOVIK A C,SHEIKH H R,et al.Image quality assessment:From error visibility to structural similarity[J].IEEE Transactions on Image Processing,2004,13(4):600-612.

[19] DOSOVITSKIY A,BROX T.Generating images with perceptual similarity metrics based on deep networks[A].Conference and Workshop on Neural Information Processing Systems[C],2016.

[20] SAXENA A,SUN M,NG A Y.Make3D:Learning 3D scene structure from a single still image[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2008,31(5):824-840.

[21] GEIGER A,LENZ P,STILLER C,et al.Vision meets robotics:The KITTI dataset[J].International Journal of Robotics Research,2013,32(11):1231-1237.

[22] MENG G,WANG Y,DUAN J,et al.Efficient image dehazing with boundary constraint and contextual regularization[A].IEEE International Conference on Computer Vision[C].IEEE,2014:6.